Par admin,

jeudi, mars 1 2012.

Security

Avoir des spams sur son blog, c’est malheureusement inévitable de nos jours, surtout si on laisse les commentaires ouverts indéfiniment comme c’est le cas sur ce blog.

Avec DotClear, les commentaires sur les articles sont fermés au bout de plusieurs semaines. Mais comme je souhaitais “jouer” un peu avec mon blog, j’ai décidé de laisser les commentaires ouverts de manière permanente.

Afin d’éviter de servir de caisse de résonnance pour les spameurs de tout poils, j’ai cependant pris quelques précautions. Tout d’abord, j’ai vérifié que les extensions anti-spam de DotClear suivantes étaient bien actives:

- IP Filter – permet de définir une liste noire ou blanche

- Bad Words – évite de devoir se poser la question en cas de commentaires avec certains mots clés douteux

- IP Lookup

- Links Lookup

- Fair Trackbacks

A vrai dire, les trois derniers filtres sont peu sollicités, car après avoir créé une liste IP de spameurs (filtrage non seulement sur l’IP mais sur tout le range de l’opérateur en question), il n’y a plus de grandes surprises qui nous attendent.

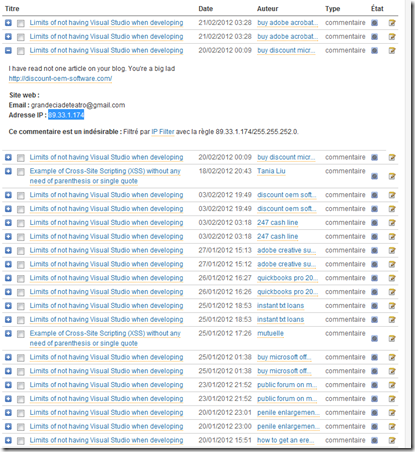

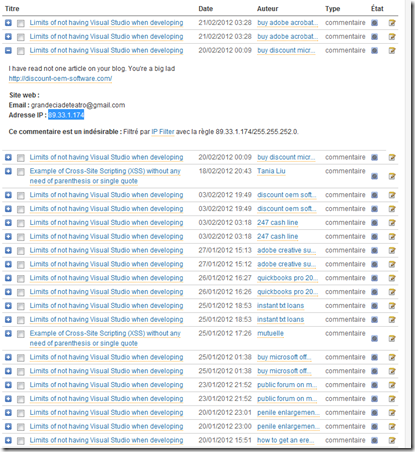

Ci-dessous se trouve une liste des derniers spams reçu, où il apparait très clairement que l’article Limits of not having Visual Studio when developing attire énormément de commentaires non sollicités:

Pourquoi donc ce grand intérêt pour cette page? Il s’avère que cet hiver, 3 commentaires étranges ont été postés précisément sur cette article, avec comme site référant http://google.com, comme adresse email hellojohnatan@aol.com et provenant tous de l’adresse IP 81.25.45.63:

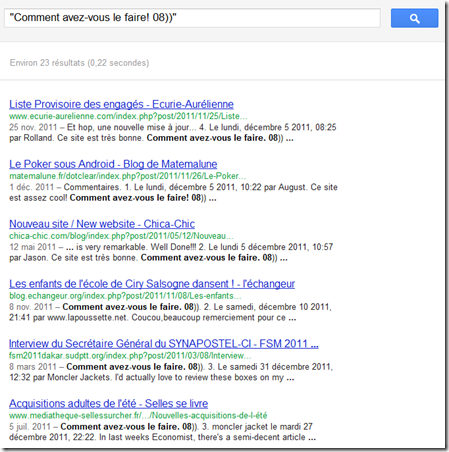

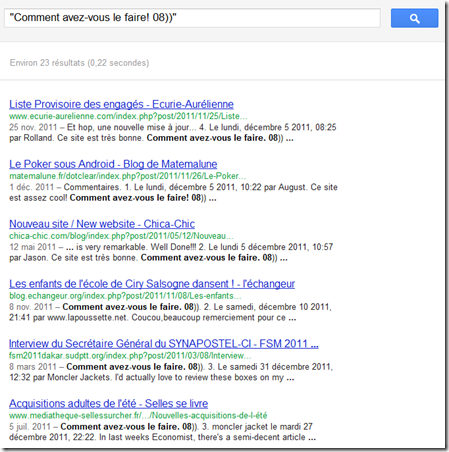

Curieux de voir un lien vers Google, j’ai laissé le commentaire en ligne. Le résultat – plusieurs dizaines de spams sur le même article est sans commentaire. Un élément de reconnaissance - la présence de 08)) et une URL pointant vers http://google.com permet au spameur de retrouver les blogs acceptant des commentaires. Une recherche exacte sur le terme, marqueur y compris, retourne plusieurs dizaines de pages:

Finalement, je me suis intéressé au parcours et logs laissé par ces visiteurs récurent. Est-ce qu’ils voient au moins mes publicités ou augmentent mes statistiques? Cela semble malheureusement peu probable, vu que le peu d’interactions avec le site – juste:

- Un GET sur la page, avec comme referal la page elle-même et aucun user-agent

- Immédiatement un POST avec le commentaire publicitaire – aucune autre ressource du site n’est chargée

- Finalement le suivi du redirect vers la page de confirmation

89.33.1.174 - - [20/Feb/2012:01:09:11 +0100] "GET /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing HTTP/1.1" 200 12463 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing" "-"

89.33.1.174 - - [20/Feb/2012:01:09:12 +0100] "POST /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing#pr HTTP/1.1" 302 12613 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing" "-"

89.33.1.174 - - [20/Feb/2012:01:09:13 +0100] "GET /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing&pub=0 HTTP/1.1" 200 12577 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing&pub=0" "-"

89.33.1.174 - - [20/Feb/2012:01:09:13 +0100] "GET /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing HTTP/1.1" 200 12463 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing" "-"

89.33.1.174 - - [20/Feb/2012:01:09:30 +0100] "POST /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing#pr HTTP/1.1" 302 12615 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing" "-"

89.33.1.174 - - [20/Feb/2012:01:09:30 +0100] "GET /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing&pub=0 HTTP/1.1" 200 12577 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing&pub=0" "-"

89.33.1.174 - - [20/Feb/2012:01:09:31 +0100] "GET /misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing HTTP/1.1" 200 12463 "https://www.ness.ch/misc/?post/2011/02/07/Limits-of-not-having-Visual-Studio-when-developing" "-"

Bref, mis à part augmenter le nombre de commentaires dans les spams, ce type de visiteur n’apporte rien que des nuisances. J’ai décidé pour l’instant de conserver les 3 commentaires “balises” actifs, mais je risque de revoir ce choix dans un proche futur.